همانطور که میم های ویروسی مانند Balenciaga Pope نشان می دهد، هوش مصنوعی مولد این روزها از نظر وفاداری بسیار چشمگیر است. جدیدترین سیستمها میتوانند مناظری را از خط افق شهر تا کافهها ایجاد کنند و تصاویری را ایجاد کنند که به طرز شگفتانگیزی واقعی به نظر میرسند – حداقل در نگاه اول.

اما یکی از ضعف های قدیمی مدل های هوش مصنوعی متن به تصویر، از قضا متن است. حتی بهترین مدلها هم برای تولید تصاویر با آرمهای خوانا، بسیار کمتر از متن، خوشنویسی یا فونت، تلاش میکنند.

اما ممکن است تغییر کند.

هفته گذشته، DeepFloyd، یک گروه تحقیقاتی که توسط Stability AI پشتیبانی میشود، از DeepFloyd IF، یک مدل تبدیل متن به تصویر که میتواند «هوشمندانه» متن را در تصاویر ادغام کند، رونمایی کرد. DeepFloyd IF که بر روی مجموعه داده ای متشکل از بیش از یک میلیارد عکس و متن آموزش دیده است، که برای اجرا به یک پردازنده گرافیکی با حداقل 16 گیگابایت رم نیاز دارد، می تواند تصویری را از پیامی مانند “خرس عروسکی پوشیده از پیراهنی که روی آن نوشته شده است “Deep Floyd” ایجاد کند. “” – به صورت اختیاری در طیف وسیعی از سبک ها.

DeepFloyd IF به صورت متن باز در دسترس است، مجوز به گونه ای که استفاده تجاری را ممنوع می کند – در حال حاضر. این محدودیت احتمالاً ناشی از وضعیت حقوقی ضعیف فعلی مدلهای هنری مولد هوش مصنوعی است. چندین فروشنده مدل تجاری مورد انتقاد هنرمندانی قرار گرفتهاند که ادعا میکنند فروشندگان از کارشان سود میبرند، بدون اینکه به آنها غرامتی بدهند و بدون اجازه آن اثر را از وب پاک کنند.

اما کافه شبانه، پلتفرم هنری مولد، دسترسی زودهنگام به DeepFloyd IF را دریافت کرد.

آنگوس راسل، مدیر عامل کافه شبانه، با TechCrunch در مورد اینکه چه چیزی DeepFloyd IF را از سایر مدلهای تبدیل متن به تصویر متمایز میکند و اینکه چرا ممکن است گامی مهم به جلو برای هوش مصنوعی مولد باشد صحبت کرد.

به گفته راسل، طراحی DeepFloyd IF به شدت از مدل Imagen گوگل الهام گرفته شده است که هرگز به صورت عمومی منتشر نشد. برخلاف مدلهایی مانند OpenAI’s DALL-E 2 و Stable Diffusion، DeepFloyd IF از چندین فرآیند مختلف که در یک معماری ماژولار روی هم قرار گرفتهاند برای تولید تصاویر استفاده میکند.

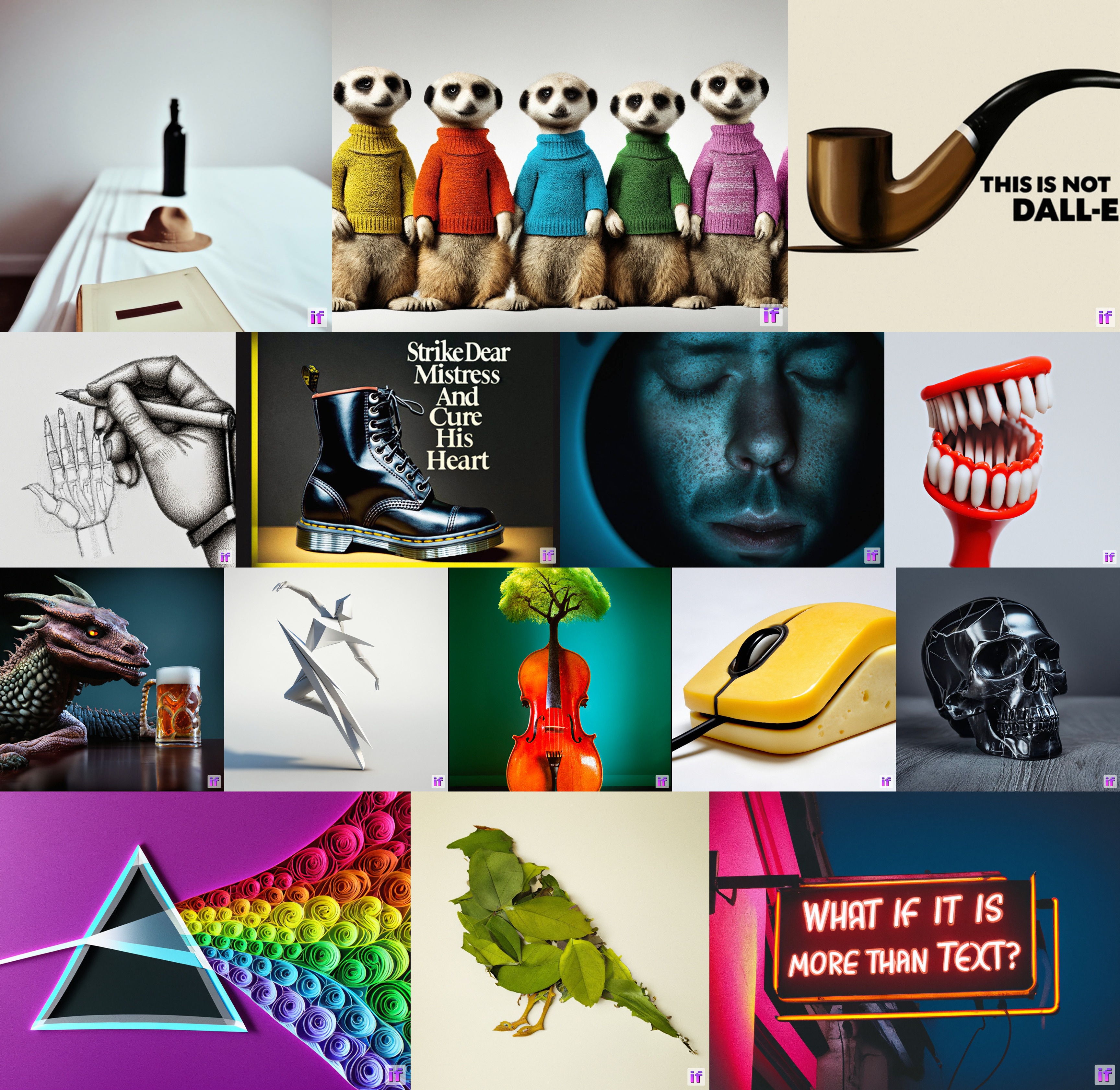

اعتبار تصویر: دیپ فلوید

با یک مدل انتشار معمولی، مدل یاد میگیرد که چگونه به تدریج نویز را از یک تصویر شروع که تقریباً به طور کامل از نویز ساخته شده است کم کند و آن را گام به گام به اعلان هدف نزدیکتر کند. DeepFloyd IF انتشار را نه یک بار بلکه چندین بار انجام می دهد و یک تصویر 64x64px ایجاد می کند و سپس تصویر را به 256x256px و در نهایت به 1024x1024px ارتقا می دهد.

چرا به مراحل انتشار چندگانه نیاز است؟ راسل توضیح داد که DeepFloyd IF مستقیماً با پیکسل ها کار می کند. مدلهای انتشار در بیشتر موارد مدلهای انتشار پنهان هستند، که اساساً به این معنی است که در فضایی با ابعاد پایینتر کار میکنند که پیکسلهای بسیار بیشتری را نشان میدهد اما به روشی کمتر دقیق.

تفاوت کلیدی دیگر بین DeepFloyd IF و مدل هایی مانند Stable Diffusion و DALL-E 2 این است که اولی از یک مدل زبان بزرگ برای درک و نمایش اعلان ها به عنوان یک بردار، یک ساختار داده پایه استفاده می کند. Due به اندازه مدل زبان بزرگ تعبیه شده در معماری DeepFloyd IF، این مدل به ویژه در درک اعلان های پیچیده و حتی روابط فضایی توصیف شده در اعلان ها خوب است (مثلاً “مکعب قرمز در بالای یک کره صورتی”)

راسل افزود: «همچنین در تولید متن خوانا و با املای صحیح در تصاویر بسیار خوب است و حتی میتواند اعلانها را در چندین زبان درک کند. از میان این قابلیتها، توانایی تولید متن خوانا در تصاویر، شاید بزرگترین پیشرفت با DeepFloyd IF باشد که از دیگر الگوریتمها متمایز است.

از آنجایی که DeepFloyd IF میتواند به خوبی متن را در تصاویر تولید کند، راسل انتظار دارد موجی از امکانات هنری مولد جدید را باز کند – طراحی لوگو، طراحی وب، پوسترها، بیلبوردها و حتی میمها. او میگوید این مدل همچنین باید در تولید چیزهایی مانند دستها بسیار بهتر باشد، و – چون میتواند اعلانهای زبانهای دیگر را درک کند – ممکن است بتواند متنی را در آن زبانها نیز ایجاد کند.

“راسل گفت: کاربران NightCafe در مورد DeepFloyd IF تا حد زیادی به دلیل امکاناتی که با تولید متن در تصاویر باز می شود هیجان زده هستند. “Stable Diffusion XL اولین الگوریتم منبع باز بود که در تولید متن پیشرفت کرد – می تواند یک یا دو کلمه را با دقت تولید کند. مقداری در آن زمان – اما هنوز برای مواردی که متن مهم است به اندازه کافی خوب نیست.

این بدان معنا نیست که DeepFloyd IF جام مقدس مدل های متن به تصویر است. راسل خاطرنشان می کند که مدل پایه dتصاویری کاملاً مشابه ایجاد نمی کند زیبا و دل انگیز به عنوان برخی از مدل های انتشار، اگرچه او انتظار دارد که تنظیم دقیق آن را بهبود بخشد.

اعتبار تصویر: دیپ فلوید

اما سوال بزرگتر برای من این است که DeepFloyd IF تا چه حد از همان نقصهایی رنج میبرد که برادران هوش مصنوعی مولد خود دارند.

تعداد فزاینده ای از تحقیقات به شکل های نژادی، قومیتی، جنسیتی و سایر اشکال کلیشه ای در هوش مصنوعی تولید کننده تصویر، از جمله Stable Diffusion، نشان داده است. در همین ماه، محققان استارتآپ Hugging Face و دانشگاه لایپزیگ ابزاری را منتشر کردند که نشان میدهد مدلهایی از جمله Stable Diffusion و OpenAI’s DALL-E 2 تمایل دارند تصاویری از افرادی که سفید و مرد به نظر میرسند تولید کنند، به ویژه زمانی که از آنها خواسته میشود افرادی را در موقعیتهای قدرت به تصویر بکشند. .

تیم DeepFloyd، به اعتبار خود، به پتانسیل تعصبات در چاپ ظریف همراه با DeepFloyd IF اشاره می کند:

متون و تصاویر جوامع و فرهنگهایی که از زبانهای دیگر استفاده میکنند احتمالاً به اندازه کافی توضیح داده نمیشوند. این بر خروجی کلی مدل تأثیر می گذارد، زیرا فرهنگ های سفید و غربی اغلب به عنوان پیش فرض تنظیم می شوند.

جدای از این، DeepFloyd IF، مانند سایر مدلهای منبع باز تولیدی، میتواند برای آسیبهایی مانند ایجاد دیپفیک افراد مشهور پورنوگرافی و تصاویر گرافیکی خشونت استفاده شود. در صفحه وب رسمی DeepFloyd IF، تیم DeepFloyd میگوید که از «فیلترهای سفارشی» برای حذف واترمارک، «NSFW» و «سایر محتوای نامناسب» از دادههای آموزشی استفاده کردهاند.

اما دقیقاً مشخص نیست که کدام محتوا حذف شده است – و چه مقدار ممکن است از دست رفته باشد. در نهایت زمان مشخص خواهد کرد.