اغلب گفته میشود که مدلهای زبان بزرگ (LLM) در امتداد خطوط ChatGPT OpenAI یک جعبه سیاه هستند و مطمئناً حقیقتی در آن وجود دارد. حتی برای دانشمندان داده، دشوار است که بدانند چرا، همیشه، یک مدل به روشی که انجام می دهد، مانند اختراع حقایق از روی پارچه، پاسخ می دهد.

در تلاشی برای جدا کردن لایههای LLM، OpenAI در حال توسعه ابزاری برای شناسایی خودکار بخشهای یک LLM است که مسئول کدام یک از رفتارهای آن است. مهندسان پشت آن تاکید می کنند که در مراحل اولیه است، اما کد اجرای آن از امروز صبح به صورت متن باز در GitHub در دسترس است.

ما سعی می کنیم [develop ways to] ویلیام ساندرز، مدیر تیم تفسیرپذیری OpenAI در مصاحبه ای تلفنی به TechCrunch گفت: مشکلات سیستم هوش مصنوعی را پیش بینی کنید. ما میخواهیم واقعاً بتوانیم بدانیم که میتوانیم به کاری که مدل انجام میدهد و پاسخی که تولید میکند اعتماد کنیم.»

برای این منظور، ابزار OpenAI از یک مدل زبان (به طعنه) استفاده میکند تا عملکرد اجزای دیگر LLMهای سادهتر از نظر معماری – بهویژه GPT-2 خود OpenAI را مشخص کند.

ابزار OpenAI تلاش می کند تا رفتارهای نورون ها را در یک LLM شبیه سازی کند.

چگونه؟ ابتدا یک توضیح سریع در مورد LLM برای پس زمینه. مانند مغز، آنها از «نورونها» تشکیل شدهاند که الگوی خاصی را در متن مشاهده میکنند تا بر آنچه که مدل کلی «میگوید» بعد تأثیر بگذارد. به عنوان مثال، با توجه به درخواستی در مورد ابرقهرمانان (مثلاً «کدام ابرقهرمانان مفیدترین ابرقدرتها را دارند؟»)، یک «نرون ابرقهرمانی مارول» ممکن است احتمال نامگذاری ابرقهرمانهای خاص فیلمهای مارول را افزایش دهد.

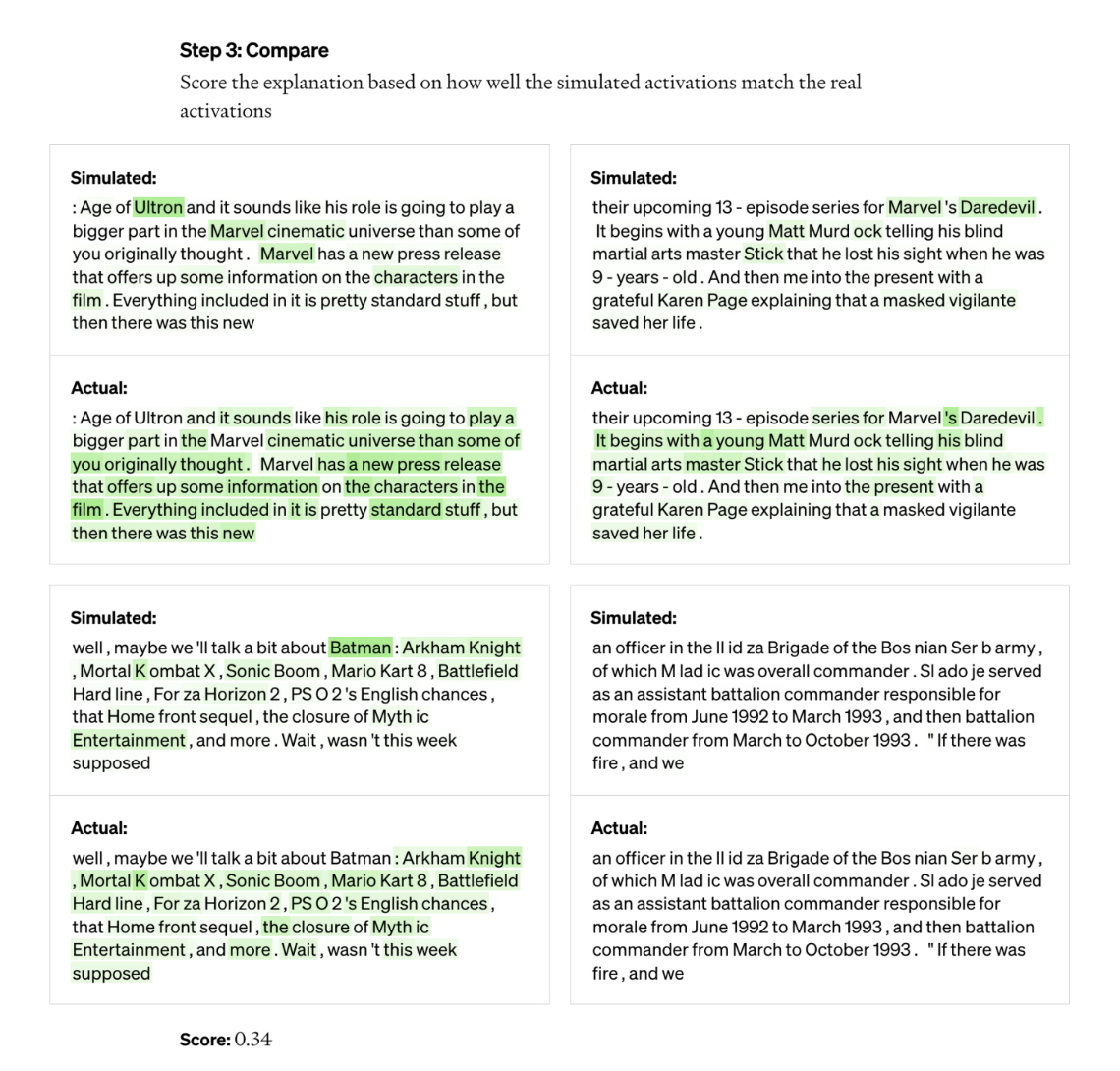

ابزار OpenAI از این راهاندازی برای تجزیه مدلها به تکههای جداگانه آنها استفاده میکند. ابتدا، این ابزار توالیهای متنی را در مدل مورد ارزیابی اجرا میکند و منتظر مواردی میماند که یک نورون خاص مکرراً «فعال میشود». در مرحله بعد، GPT-4، آخرین مدل هوش مصنوعی تولید متن OpenAI، این نورونهای بسیار فعال را نشان میدهد و دارای GPT-4 است که توضیحی را ایجاد میکنند. برای تعیین دقیق بودن توضیح، این ابزار GPT-4 را با دنبالههای متنی ارائه میکند و از آن میخواهد نحوه رفتار نورون را پیشبینی یا شبیهسازی کند. سپس رفتار نورون شبیه سازی شده را با رفتار نورون واقعی مقایسه می کند.

جف وو، سرپرست تیم تحقیق، میگوید: «با استفاده از این روش، اساساً میتوانیم برای هر نورون، نوعی توضیح اولیه زبان طبیعی برای کاری که انجام میدهد و همچنین امتیازی برای اینکه چقدر این توضیح با رفتار واقعی مطابقت دارد، داشته باشیم. تیم تراز مقیاس پذیر در OpenAI گفت. ما از GPT-4 به عنوان بخشی از فرآیند برای تولید توضیحاتی در مورد آنچه که یک نورون به دنبال آن است استفاده می کنیم و سپس ارزیابی می کنیم که چقدر این توضیحات با واقعیت کاری که انجام می دهد مطابقت دارد.

محققان توانستند توضیحاتی را برای تمام 307200 نورون در GPT-2 ایجاد کنند که آنها را در مجموعه داده ای که در کنار کد ابزار منتشر شده است گردآوری کردند.

به گفته محققان، ابزارهایی مانند این می توانند روزی برای بهبود عملکرد یک LLM مورد استفاده قرار گیرند – به عنوان مثال برای کاهش سوگیری یا سمیت. اما آنها تصدیق می کنند که راه درازی در پیش است تا اینکه واقعاً مفید باشد. این ابزار در توضیحات خود برای حدود 1000 نورون، کسری کوچک از کل، مطمئن بود.

یک فرد بدبین نیز ممکن است استدلال کند که این ابزار اساساً یک تبلیغ برای GPT-4 است، با توجه به اینکه برای کار کردن به GPT-4 نیاز دارد. سایر ابزارهای تفسیرپذیر LLM کمتر به APIهای تجاری وابسته هستند، مانند DeepMind’s Tracr، کامپایلری که برنامه ها را به مدل های شبکه عصبی ترجمه می کند.

وو گفت که اینطور نیست – این واقعیت که ابزار از GPT-4 استفاده می کند صرفاً “تصادفی” است – و برعکس، ضعف های GPT-4 را در این زمینه نشان می دهد. او همچنین گفت که با برنامه های تجاری در ذهن ایجاد نشده است و از نظر تئوری، می تواند برای استفاده از LLM ها در کنار GPT-4 سازگار شود.

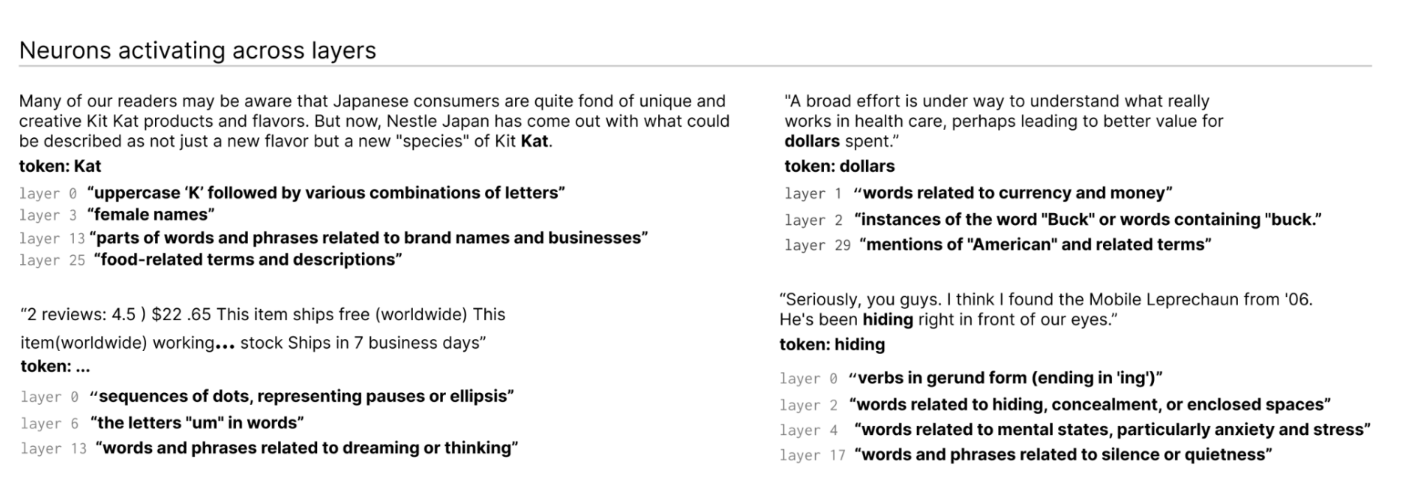

این ابزار نورونهایی را که در سراسر لایههای LLM فعال میشوند، شناسایی میکند.

وو گفت: “بیشتر توضیحات نمره بسیار ضعیفی دارند یا آنقدر از رفتار نورون واقعی را توضیح نمی دهند.” “برای مثال، بسیاری از نورونها بهگونهای فعال هستند که تشخیص آنچه در حال رخ دادن است بسیار سخت است – مثل اینکه روی پنج یا شش چیز مختلف فعال میشوند، اما هیچ الگوی قابل تشخیصی وجود ندارد. گاهی اونجا است یک الگوی قابل تشخیص است، اما GPT-4 قادر به یافتن آن نیست.

این یعنی مدلهای پیچیدهتر، جدیدتر و بزرگتر، یا مدلهایی که میتوانند وب را برای کسب اطلاعات مرور کنند. اما در مورد دوم، وو معتقد است که مرور وب مکانیسمهای اساسی ابزار را تغییر چندانی نمیدهد. او میگوید که میتوان آن را به سادگی تغییر داد تا بفهمیم چرا نورونها تصمیم میگیرند که جستجوهای خاصی را در موتورهای جستجو ایجاد کنند یا به وبسایتهای خاصی دسترسی پیدا کنند.

وو گفت: “ما امیدواریم که این مسیر امیدوارکننده ای را برای پرداختن به تفسیرپذیری به روشی خودکار باز کند که دیگران بتوانند روی آن کار کنند و در آن مشارکت کنند.” “امید این است که ما واقعاً نه تنها توضیح خوبی در مورد اینکه نورونها به چه چیزی پاسخ میدهند، بلکه به طور کلی، رفتار این مدلها – چه نوع مدارهایی را محاسبه میکنند و چگونه نورونهای خاصی بر روی دیگر نورونها تاثیر میگذارند، داشته باشیم.”