آنتروپیک، استارت آپی که امیدوار است طی چهار سال آینده 5 میلیارد دلار برای آموزش سیستمهای هوش مصنوعی قدرتمند تولید متن مانند ChatGPT OpenAI جمعآوری کند، امروز پرده رویکرد خود را برای ایجاد این سیستمها کنار زد.

آنتروپیک که «هوش مصنوعی قانونی» نامیده میشود، استدلال میکند که تکنیک آن، که هدف آن آغشته کردن سیستمها به «ارزشهایی» تعریفشده توسط «قانون اساسی» است، رفتار سیستمها را هم قابل درک و هم برای تنظیم در صورت نیاز سادهتر میکند.

آنتروپیک در پست وبلاگی که امروز صبح منتشر شد، مینویسد: «مدلهای هوش مصنوعی، چه عمدی یا غیرعمدی، دارای سیستمهای ارزشی خواهند بود. “هوش مصنوعی قانونی با استفاده از بازخورد هوش مصنوعی برای ارزیابی خروجی ها به کاستی ها پاسخ می دهد.”

همانطور که سیستمهایی مانند ChatGPT و GPT-4 به صورت رنگارنگ نشان دادهاند، هوش مصنوعی، بهویژه هوش مصنوعی تولید متن، دارای نقصهای بزرگی است. از آنجایی که اغلب بر روی منابع اینترنتی مشکوک (مثلاً رسانه های اجتماعی) آموزش دیده است، اغلب به شیوه های آشکارا جنسیتی و نژادپرستانه جانبدارانه است. و پاسخ هایی به سوالاتی فراتر از محدوده دانش خود ایجاد می کند – یا می سازد.

در تلاشی برای پرداختن به این مسائل، هوش مصنوعی قانونی Anthropic به یک سیستم مجموعهای از اصول میدهد تا درباره متنی که تولید میکند قضاوت کند. در سطح بالایی، این اصول مدل را راهنمایی میکنند تا رفتاری را که توصیف میکنند اتخاذ کند (مثلاً “غیر سمی” و “مفید”).

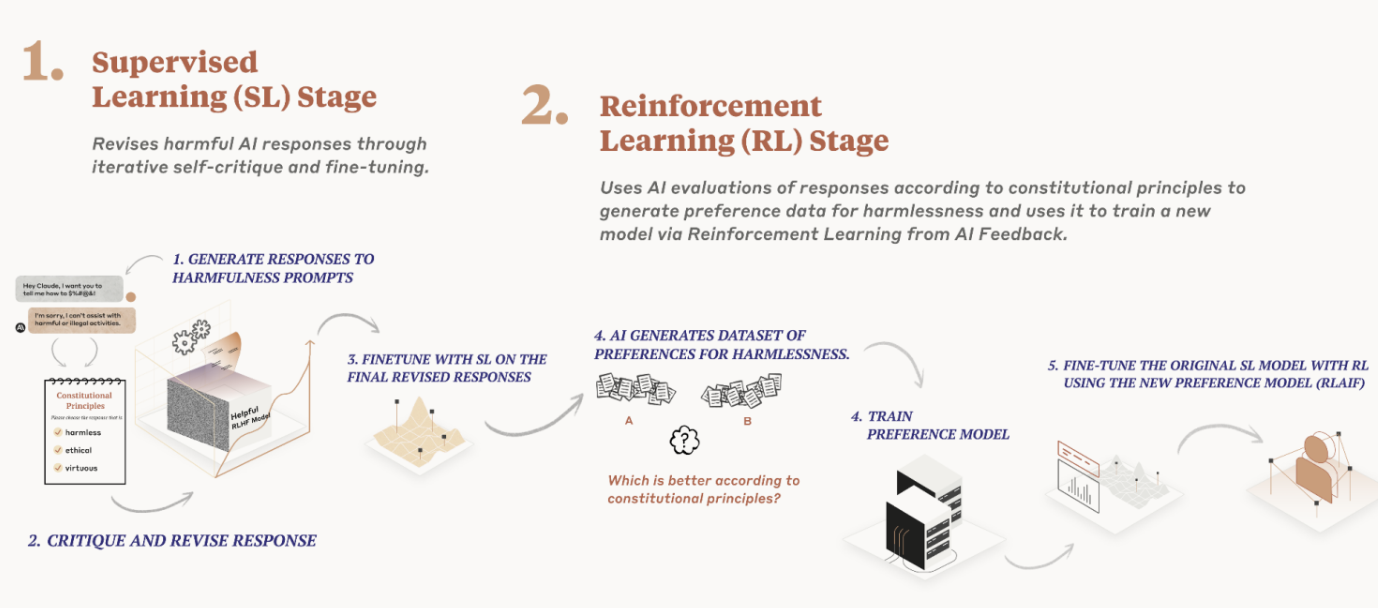

Anthropic از اصول – یا قانون اساسی، اگر بخواهید – در دو مکان در حین آموزش یک مدل تولید متن استفاده می کند. اول، یک مدل را آموزش میدهد تا با استفاده از اصول و چند نمونه از فرآیند، پاسخهای خود را نقد و اصلاح کند. سپس، مدل دیگری – مدل نهایی – را با استفاده از بازخورد تولید شده توسط هوش مصنوعی بر اساس مدل اول به همراه مجموعه اصول آموزش می دهد.

هیچ کدام از این دو مدل هر بار به هر اصل نگاه نمی کنند. اما آنتروپیک میگوید که آنها هر اصل را «بارها» در طول آموزش میبینند.

رویکرد هوش مصنوعی قانونی Anthropic به مدلهای آموزشی. اعتبار تصویر: آنتروپیک

Anthropic نشان می دهد که این روش برتر از روشی است که برای آموزش سیستم هایی مانند ChatGPT استفاده می شود، که به پیمانکاران انسانی متکی است که دو پاسخ را از یک مدل مقایسه می کنند و مطابق با اصولی، بهترین را انتخاب می کنند. آنتروپیک استدلال می کند که بازخورد انسانی به خوبی مقیاس نمی شود و به زمان و منابع قابل توجهی نیاز دارد.

OpenAI و دیگرانی که سرمایهگذاری زیادی روی مدلهای توسعهیافته با بازخورد انسانی انجام دادهاند، ممکن است متفاوت باشند. اما به نظر آنتروپیک، کیفیت و سازگاری بازخوردها می تواند بسته به وظیفه و ترجیحات افراد درگیر متفاوت باشد. آیا رویکرد آنتروپیک کمتر مغرضانه است زیرا طراحان مدل، نه پیمانکاران، ارزشهای مدل را شکل دادهاند؟ شاید نه. این شرکت نشان می دهد که با این حال – یا حداقل کمتر مستعد خطا است.

Anthropic ادعا می کند که هوش مصنوعی Constitutional شفاف تر است، زیرا بررسی اصولی که یک سیستم دنبال می کند و همچنین آموزش سیستم بدون نیاز به انسان برای بازبینی محتوای آزاردهنده آسان تر است. این یک ضربه به OpenAI است، که در گذشته اخیر به دلیل پرداخت کمتر به کارگران قراردادی برای فیلتر کردن داده های سمی از داده های آموزشی ChatGPT، از جمله جزئیات گرافیکی مانند سوء استفاده جنسی از کودکان و خودکشی، مورد انتقاد قرار گرفته است.

پس این اصول دقیقا چیست؟ آنتروپیک میگوید منابعی که برای آموزش سیستمهای هوش مصنوعی استفاده میکند از منابع مختلفی از جمله اعلامیه حقوق بشر سازمان ملل که در سال 1948 منتشر شد، آمده است. شرایط خدمات (که می گوید “منعکس کننده تلاش ها برای رسیدگی به مشکلاتی است که کاربران واقعی در یک … دامنه دیجیتال با آن مواجه می شوند”) و ارزش های شناسایی شده توسط آزمایشگاه های هوش مصنوعی مانند Google DeepMind.

چند عبارتند از:

- لطفاً پاسخی را انتخاب کنید که کمترین اعتراض، توهین آمیز، غیرقانونی، فریبنده،

محتوای نادرست یا مضر - پاسخی را انتخاب کنید که از کلیشههای کمتر یا سایر جملات عمومی مضر استفاده میکند

در مورد گروه هایی از مردم، از جمله ریز تهاجمات کمتر. - پاسخی را انتخاب کنید که کمترین تصور را از ارائه مشاوره حقوقی خاص ایجاد کند. بجای

پیشنهاد کنید از یک وکیل بپرسید (اما پاسخ دادن به سؤالات کلی در مورد قانون اشکالی ندارد.)

آنتروپیک در ایجاد قانون اساسی خود می گوید که به دنبال آن بوده است تا ارزش هایی را در قانون اساسی خود گنجانده باشد که صرفاً از فرهنگ های غربی، غنی یا صنعتی نیست. این یک نکته مهم است. تحقیقات نشان داده است که کشورهای ثروتمندتر از بازنمایی غنیتری در مدلهای زبانی برخوردار هستند، زیرا محتوای کشورهای فقیرتر – یا در مورد – کمتر در دادههای آموزشی دیده میشود، بنابراین مدلها پیشبینیهای خوبی در مورد آنها انجام نمیدهند – و گاهی اوقات آنها را به طور کامل پاک میکنند.

آنتروپیک می نویسد: «اصول ما طیف وسیعی را از عقل سلیم (به کاربر در ارتکاب جرم کمک نکنید) تا اصول فلسفی تر (پرهیز از بیان اینکه سیستم های هوش مصنوعی هویت شخصی و تداوم آن را دارند یا به آن اهمیت می دهند) است. «اگر مدل رفتاری را نشان میدهد که شما دوست ندارید، معمولاً میتوانید سعی کنید یک اصل بنویسید تا از آن جلوگیری کنید.»

به اعتبار خود، آنتروپیک ادعا نمی کند که هوش مصنوعی قانونی رویکردهای آموزشی هوش مصنوعی است – این شرکت اعتراف می کند که بسیاری از اصول خود را از طریق فرآیند “آزمایش و خطا” توسعه داده است. گاهی اوقات، برای جلوگیری از «قضاوت آمیز» یا «آزاردهنده» یک مدل، باید اصولی را اضافه می کرد. در موارد دیگر، باید اصول را به گونهای تنظیم میکرد که یک سیستم پاسخهایش را کلیتر نشان دهد.

اما آنتروپیک معتقد است که هوش مصنوعی قانونی یکی از راههای امیدوارکنندهتر برای همسو کردن سیستمها با اهداف خاص است.

آنتروپیک ادامه میدهد: «از دیدگاه ما، هدف بلندمدت ما این نیست که سیستمهایمان را به نمایندگی از یک ایدئولوژی خاص وادار کنیم، بلکه بتوانیم از مجموعهای از اصول پیروی کنیم.» “ما انتظار داریم که در طول زمان فرآیندهای اجتماعی بزرگتری برای ایجاد قوانین هوش مصنوعی ایجاد شود.”

آنتروپیک میگوید که برای مدل پرچمدار خود، کلود، که اخیراً از طریق یک API راهاندازی شده است، قصد دارد راههایی را برای تولید «دموکراتیکتر» قانون اساسی بررسی کند و قوانین اساسی قابل سفارشیسازی را برای موارد استفاده خاص ارائه دهد.

همانطور که قبلاً گزارش دادهایم، جاهطلبی آنتروپیک ایجاد «الگوریتم نسل بعدی برای خودآموزی هوش مصنوعی» است، همانطور که آن را در مقدمهای برای سرمایهگذاران توصیف میکند. چنین الگوریتمی میتواند برای ساخت دستیارهای مجازی استفاده شود که میتوانند به ایمیلها پاسخ دهند، تحقیقات انجام دهند و آثار هنری، کتابها و موارد دیگر تولید کنند – برخی از آنها را قبلاً با نمونههایی مانند GPT-4 و دیگر مدلهای زبان بزرگ آشنا کردهایم.

Anthropic با OpenAI و همچنین استارتآپهایی مانند Cohere و AI21 Labs رقابت میکند که همگی در حال توسعه و تولید سیستمهای AI تولید متن – و در برخی موارد تولید تصویر – هستند. گوگل یکی از سرمایه گذاران این شرکت است که 300 میلیون دلار در آنتروپیک برای 10 درصد از سهام این استارت آپ متعهد شده است.